Robots.txt est un fichier fondamental et important sur votre site Web. Son but est de donner des instructions aux robots des moteurs de recherche sur les URL qu’ils ne doivent pas explorer sur votre site Web. Il est impératif de comprendre ce qu’est un fichier robots.txt, d’un point de vue technique , comment il fonctionne, comment donner des instructions aux crawlers et comment tester la validité et l’efficacité de ces instructions.

Cet article vous guidera à travers les tenants et les aboutissants du fichier robots.txt, afin que vous puissiez comprendre de quoi il s’agit et comment l’utiliser pour vous aider dans vos efforts de référencement et gagner plus de résultats de recherche.

Qu’est-ce qu’un fichier robots.txt ?

Le fichier robots.txt est un simple fichier texte qui se trouve dans le répertoire racine de votre site Web. Il donne des instructions aux robots des moteurs de recherche sur les pages à explorer sur votre site Web. Les instructions valides sont basées sur la norme d’exclusion des robots, qui sera abordée dans cet article. Ces instructions sont au moyen de User-Agent et Disallow.

La combinaison de User-Agent et Disallow indique aux robots des moteurs de recherche les URL qu’ils ne peuvent pas explorer sur votre site Web. Un fichier robots.txt qui ne contient que User-Agent : * Disallow : / est parfaitement valide. Dans ce cas, les instructions données aux crawlers sont d’empêcher l’intégralité du site d’être crawlé.

Les robots d’exploration accèdent à votre site et ajoutent les URL à la file d’attente d’exploration. Ils le font pour les URL nouvellement découvertes et précédemment connues. Un robot d’exploration vérifiera d’abord le répertoire racine de votre site Web, à la recherche du fichier robots.txt. S’il n’y est pas, ils exploreront l’intégralité de votre site. Cependant, si un robots.txt existe, il explorera votre site Web conformément aux directives que vous spécifiez.

La principale raison de la mise à jour et de la maintenance d’un fichier robots.txt pour votre site Web est que votre site Web ne s’enlise pas avec des requêtes excessives de robots. Robots.txt n’est pas un moyen d’empêcher les pages d’être indexées par Google.

Un mythe courant est que les directives de votre fichier robots.txt peuvent être utilisées pour empêcher les pages de se retrouver dans les résultats de recherche Google. La réalité est que Google peut toujours indexer vos pages s’il existe d’autres signaux, tels que des liens provenant d’autres sites Web.

Une mauvaise configuration de votre robots.txt peut avoir de graves conséquences pour votre site Web. Dire par erreur aux crawlers de ne pas accéder à vos pages peut être coûteux. Ce problème peut être encore amplifié pour les très grands sites Web. Vous pourriez empêcher par inadvertance les robots d’exploration d’accéder à de grandes portions de pages essentielles.

De plus, il n’est pas certain que tous les robots des moteurs de recherche obéissent aux directives que vous avez spécifiées dans votre fichier robots.txt. La plupart des crawlers légitimes n’exploreront pas les pages bloquées par robots.txt. Cependant, certains robots malveillants peuvent l’ignorer. N’utilisez donc pas robots.txt pour protéger les pages sensibles de votre site.

Ajout et modification de robots.txt sur votre serveur

Vous aurez besoin d’avoir accès pour pouvoir ajouter un fichier robots.txt. Certaines plates-formes CMS, telles que WordPress, vous permettent d’ajouter/modifier votre fichier robots.txt.

Ajouter un fichier robots.txt

Si vous avez accès à vos fichiers d’hébergement Web via un cPanel ou une autre console de gestion d’hébergement similaire, vous pouvez créer un fichier robots.txt si vous n’en avez pas déjà un.

Vous devrez peut-être ajouter un fichier robots.txt en le téléchargeant via FTP. Il s’agit d’une tâche courante et votre fournisseur d’hébergement Web peut vous orienter dans la bonne direction.

Modifier un fichier robots.txt

Si le plugin Yoast est installé pour WordPress, vous pouvez modifier votre fichier robots.txt directement depuis le tableau de bord.

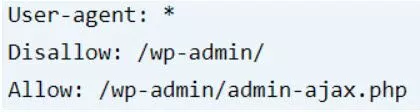

Par défaut, le fichier robots.txt pour WordPress ressemblera à ce qui suit.

Pour commencer à modifier votre fichier robots.txt avec Yoast, procédez comme suit :

- Cliquez sur « SEO » dans le menu Yoast de gauche dans le tableau de bord WordPress.

- Cliquez sur « Outils » dans les options de paramètres étendues.

- Cliquez sur « Éditeur de fichiers », et vous pouvez maintenant modifier votre fichier robots.txt.

Remarque : Assurez-vous que l’édition de fichiers est activée, sinon cette option ne sera pas disponible. - Apportez les modifications souhaitées à votre fichier robots.txt.

- Enregistrez le fichier pour vous assurer que les modifications prennent effet.

Si vous souhaitez des instructions plus détaillées, elles sont disponibles sur le site Web de Yoast .

Si vous ne pouvez pas accéder au robots.txt via votre CMS, vous devrez accéder à vos fichiers d’hébergement Web directement via cPanel ou votre console d’hébergement Web.

Comment utiliser robots.txt

Les robots des moteurs de recherche vérifieront votre fichier robots.txt avant d’explorer les URL de votre site Web. S’il y a des pages ou des sections particulières de votre site que vous ne voulez pas explorer, des pages qu’il n’est pas utile d’inclure dans les pages de résultats des moteurs de recherche, alors robots.txt peut être utilisé pour les interdire de l’exploration.

La raison la plus utile d’inclure et de maintenir un fichier robots.txt est d’optimiser le budget de crawl. Le budget de crawl est un terme utilisé pour décrire le temps et les ressources que les robots des moteurs de recherche passeront sur votre site. Le problème que vous essayez de résoudre est lorsque ces robots d’exploration gaspillent le budget d’exploration en explorant des pages inutiles ou indésirables sur votre site Web.

Briser le mythe : – bloquer l’indexation avec Robots.txt

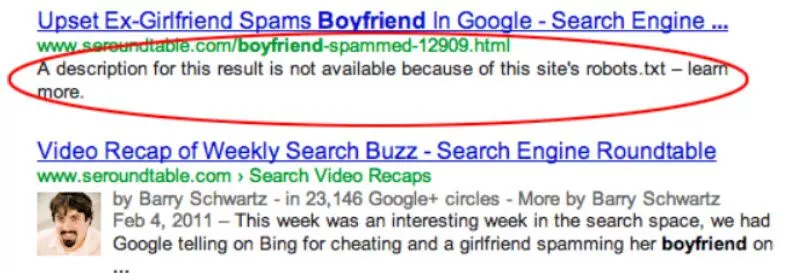

Robots.txt n’est pas un outil fiable pour empêcher les moteurs de recherche d’indexer les pages. Les pages peuvent toujours être indexées dans les résultats de recherche même si elles ne peuvent pas être explorées dans robots.txt.

S’il est empêché d’explorer votre fichier robots.txt, il n’affichera pas d’extrait de résultats de recherche détaillé décrivant la page d’index. Au lieu de cela, il affichera un message expliquant que la description n’est pas disponible à cause de la directive robots.txt.

Une page peut toujours être indexée dans un moteur de recherche si :

- La page est incluse dans le sitemap.xml.

- Il y a un lien interne pointant vers la page.

- Il y a un lien externe pointant vers le site.

Les moyens les plus fiables d’empêcher l’indexation des pages n’incluent pas du tout l’utilisation du fichier robots.txt. Il est le plus efficacement réalisé par l’utilisation de la directive Noindex. Lorsqu’un robot d’exploration de moteur de recherche lit la directive noindex, il supprime la page des résultats de la recherche, la retirant ainsi complètement de l’index.

Vous pouvez empêcher efficacement l’indexation d’une page de deux manières :

- Utilisez une balise meta.

- Utilisez un en-tête de réponse HTTP.

Norme d’exclusion des robots

La norme d’exclusion des robots vous permet de donner des instructions aux robots des moteurs de recherche. La norme fournit des moyens de donner des instructions aux robots d’exploration sur les zones de votre site qu’ils doivent ou ne doivent pas explorer. Ainsi, votre robots.txt devrait contenir une liste de vos directives les plus importantes.

Tous les robots d’exploration ou robots ne respectent pas les instructions de votre fichier robots.txt. Ces robots sont souvent appelés BadBot. Ceux-ci incluent des robots à la recherche de vulnérabilités de sécurité qui peuvent leur permettre d’explorer ou d’analyser des sections que vous avez spécifiées pour les robots. Les BadBots courants peuvent également inclure des spambots, des logiciels malveillants et des collecteurs d’e-mails.

Nous nous concentrerons ici sur les types d’instructions que nous pouvons donner aux robots des moteurs de recherche et sur la manière dont nous pouvons les aider à explorer les zones de notre site que nous souhaitons qu’ils explorent. Les bases de ceci sont faites en utilisant une combinaison de User-Agent et Disallow.

Agent utilisateur

User-Agent est utilisé pour spécifier un robot de moteur de recherche. Selon le moteur de recherche spécifique, vous pouvez spécifier l’agent utilisateur approprié que vous souhaitez interdire.

Refuser

Disallow this indique à un User-Agent de ne pas explorer certaines sections de votre site. Vous devrez placer un spécificateur après le mot Disallow pour qu’il soit valide.

Un exemple utilisé pour bloquer tous les robots :

Agent utilisateur: *

Interdire : /

Ici, nous utilisons l’astérisque pour spécifier tous les User-Agents, et nous utilisons une barre oblique pour indiquer le début de toutes les URL.

Un exemple utilisé pour interdire à Googlebot d’explorer le répertoire /photos :

Agent utilisateur : Googlebot

Interdire : /photos

Exemple utilisé pour interdire plus précisément Googlebot, puis tous les autres robots d’exploration :

Agent utilisateur : Googlebot

Interdire : /keep-out-googlebot/

Agent utilisateur: *

Interdire : /garder-le-reste/

À quoi ressemble un fichier robots.txt ?

Tous les sites Web n’incluent pas automatiquement un fichier robots.txt, vous devrez donc peut-être le créer si vous n’en avez pas déjà un. Vous pouvez vérifier s’il y en a déjà un en utilisant la barre de navigation du navigateur et en saisissant l’URL du fichier robots.txt.

Comme vous pouvez le voir dans le fichier robots.txt de StudioHawk, vous n’avez peut-être pas besoin d’un fichier long et compliqué. L’objectif principal ici est d’interdire l’exploration de la section /wp-admin/ du site Web. Cela économise le budget de crawl.

Cependant, nous souhaitons autoriser l’exploration de la page /wp-admin/admin-ajax.php car il s’agit d’une ressource qui peut être nécessaire pour aider les moteurs de recherche à comprendre comment notre site Web explore et s’affiche.

Il existe également un lien vers le plan du site Web, qui aide les moteurs de recherche à le découvrir, et il montre la propriété et la confiance. En effet, seul le propriétaire du site Web est autorisé à modifier le fichier robots.txt.

Directives d’exclusion des robots non standard

Outre les directives standard User-Agent et Disallow, vous pouvez également utiliser les directives non standard. Veuillez garder à l’esprit qu’il n’y a aucune garantie que tous les robots d’exploration des moteurs de recherche suivront toutes ces directives non standard. Cependant, pour les principaux moteurs de recherche, ceux-ci sont assez cohérents.

Permettre

Autoriser est pris en charge par les principaux robots d’exploration des moteurs de recherche et peut être utile lorsqu’il est utilisé conjointement avec une directive Disallow. Utilisez cette directive pour permettre aux robots d’exploration d’accéder à un fichier dans une directive qui peut avoir un refus sur le répertoire.

Nous avons besoin d’une petite syntaxe spécifique pour nous assurer que les principaux crawlers des moteurs de recherche respecteront la directive Allow. Assurez-vous de placer vos directives Allow dans la ligne au-dessus de Disallow.

Un exemple utilisé pour Autoriser un fichier à l’intérieur d’un répertoire avec un Interdire :

Autoriser : /répertoire/unfichier.html

Interdire : /répertoire/

Délai d’exploration

Crawl-delay n’est pas pris en charge par tous les principaux robots d’exploration des moteurs de recherche. Il est utilisé pour limiter la vitesse du crawler. Ceci est couramment utilisé lorsque votre site Web rencontre des problèmes de performances en raison d’une trop grande activité des robots d’exploration. Cependant, les mauvaises performances du site sont généralement dues à un hébergement Web inadéquat et doivent être résolues en améliorant votre hébergement.

Cependant, Google ne respecte pas le Crawl-rate, et ignorera simplement cette directive si vous l’avez spécifiée dans votre fichier robots.txt. Si vous souhaitez limiter le taux du robot d’exploration Googlebot, vous devez accéder à l’ ancienne version de Google Search Console et l’ajuster ici.

Un exemple utilisé pour définir Bingbot Crawl-delay :

Agent utilisateur : Bingbot

Permettre: /

Délai d’exploration : 10

Plan du site

Il est recommandé d’inclure votre sitemap XML dans votre fichier robots.txt. On pense que cela peut faciliter la découverte de votre plan de site, et donc aider les fichiers à être découverts et explorés plus rapidement.

Exemple de votre sitemap XML dans votre fichier robots.txt :

Plan du site : https://www.examplesite.com/sitemap.xml

Caractères génériques

Les caractères génériques sont pris en charge par tous les principaux robots d’exploration des moteurs de recherche lorsqu’ils sont correctement implémentés. Vous pouvez utiliser ces caractères génériques pour regrouper des fichiers par type de fichier. Le caractère générique remplace le nom du fichier et correspondra à tout nom de fichier où le caractère générique est utilisé.

Exemple pour empêcher l’exploration de toutes les images .png et images .jpg dans un répertoire spécifique :

Interdire : /*.png

Interdire : /private-jpg-images/*.jpg

Tester votre robots.txt

Tester les modifications avant de les mettre en ligne est une activité essentielle que les référenceurs doivent respecter. Une erreur dans votre fichier robots.txt peut empêcher les robots d’exploration d’accéder à l’intégralité de votre site Web. Cela peut entraîner des résultats préjudiciables pour les résultats de recherche et entraîner une forte baisse des classements et de lourdes pertes de trafic.

Nous vous recommandons de tester et de valider vos robots.txt avant de les mettre en ligne. Heureusement, nous avons un outil pratique pour tester robots.txt par Google . Il est disponible dans le menu Ancienne version de Google Search Console.

Clé à emporter

Robots.txt est un élément essentiel de vos efforts de référencement. S’il est mal configuré ou mal configuré, vos efforts de référencement pourraient avoir de réels impacts. Vous voudrez vous assurer que vous n’avez pas bloqué par erreur les robots d’exploration des parties les plus importantes de votre site Web.

Vous voudrez vous assurer d’empêcher les robots d’exploration d’explorer de manière excessive des URL sans importance. Empêcher les crawlers d’accéder aux URL sans importance permettra d’économiser le budget de crawl. Vous voudrez que votre budget de crawl soit consacré aux pages qui sont importantes pour les moteurs de recherche.

Les pages sans indexation sont une utilisation incorrecte de robots.txt. La meilleure façon de garder les pages hors des résultats de recherche est d’utiliser les meta robots noindex, ou X-Robots-Tag. Sinon, une page peut toujours finir par être indexée si elle est référencée par d’autres pages.

Maîtriser robots.txt est une compétence très puissante mais fondamentale pour chaque SEO. Comprendre comment cela fonctionne et quand l’utiliser vous aidera à mieux contrôler vos résultats SEO.

Leave A Comment